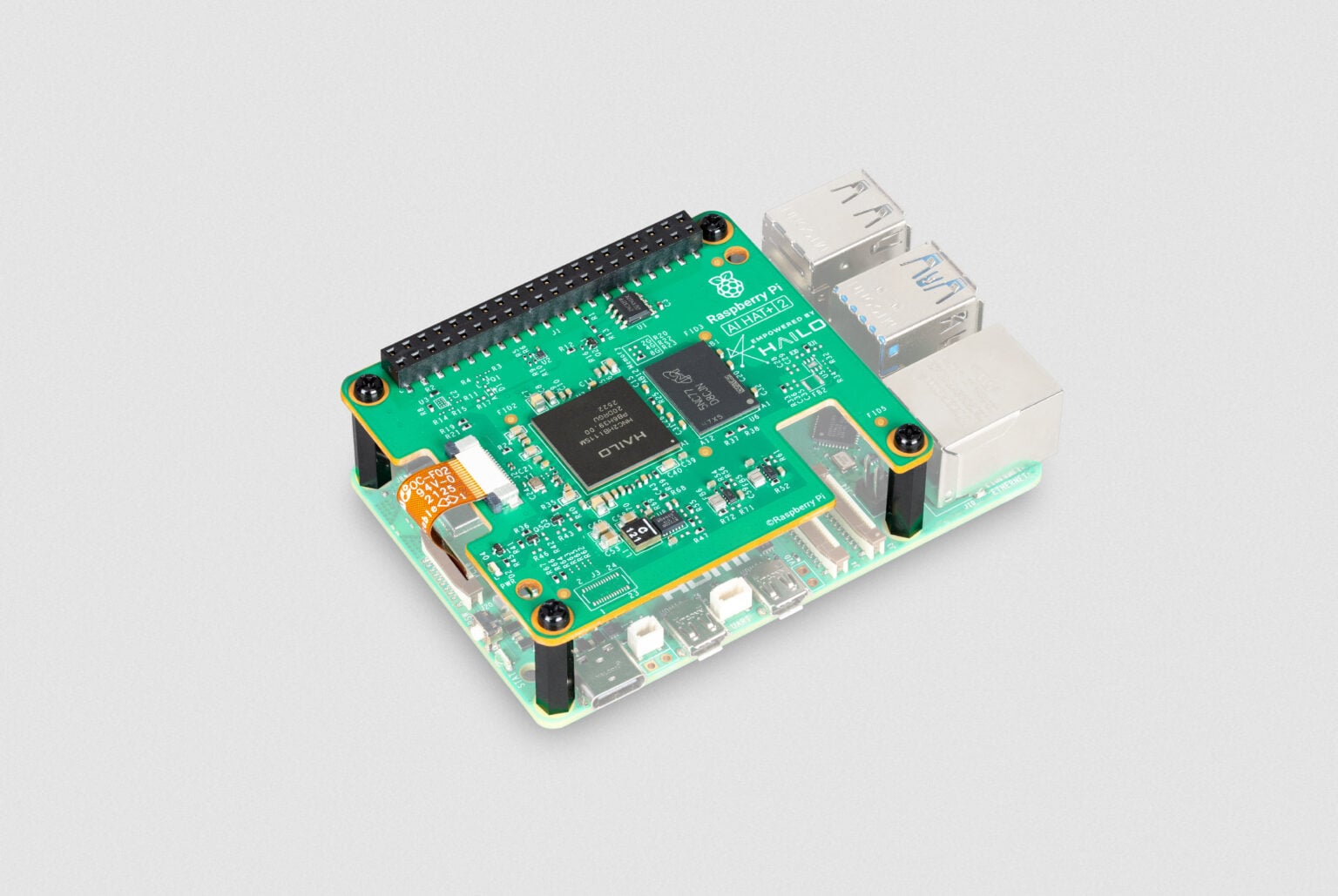

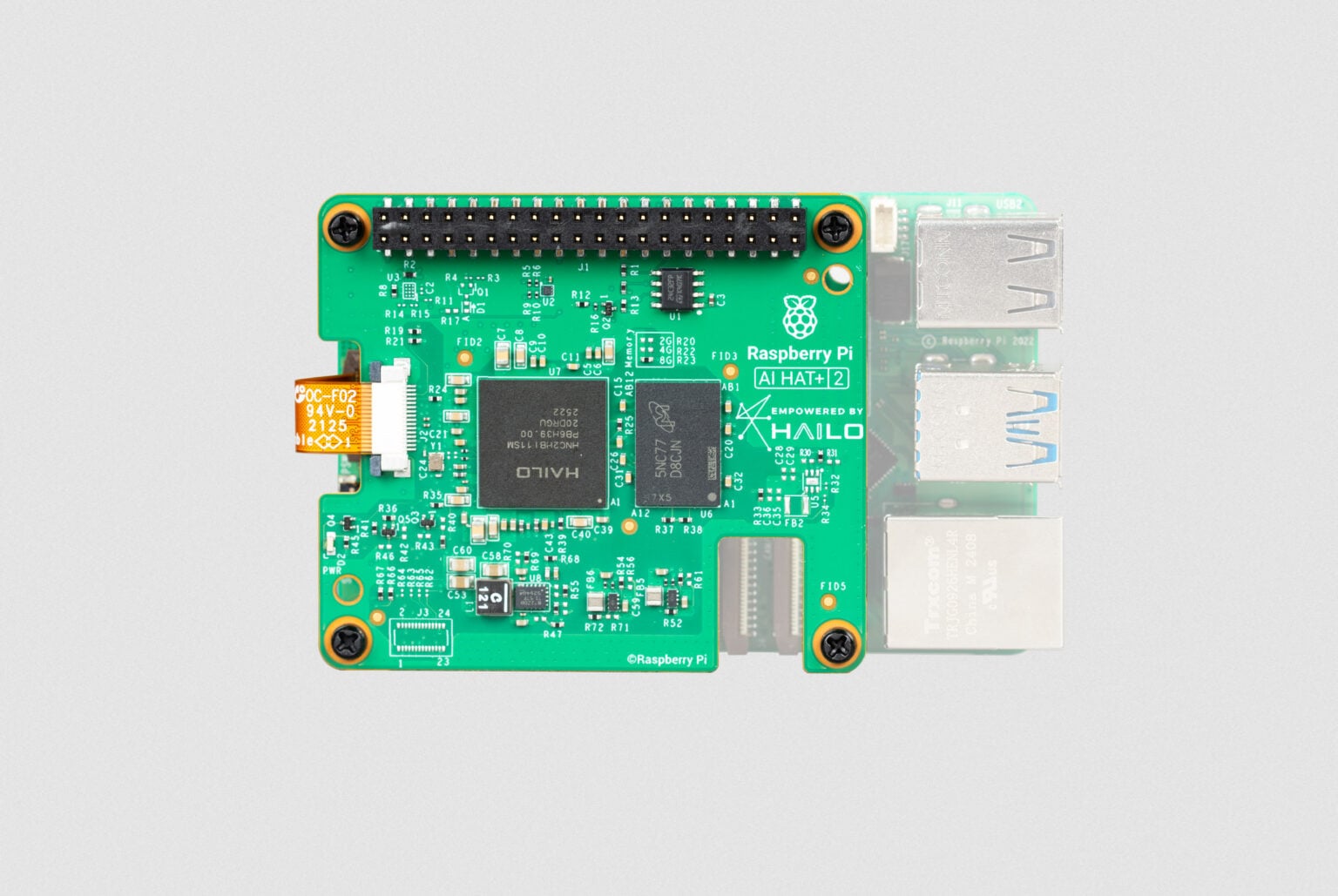

在一年前,树莓派官方推出了首款 AI 扩展板 — Raspberry Pi AI HAT+。这款基于 Hailo-8 / Hailo-8L 神经网络加速器的产品,为 Raspberry Pi 5 带来了强大的本地 AI 推理能力,使用户能够在设备端完成目标识别、姿态估计和场景分割等视觉任务,同时兼顾数据隐私与使用成本,无需依赖云端 AI 服务。

不过,随着 生成式 AI(Generative AI) 的迅速普及,原有的 AI HAT+ 在运行大语言模型(LLM)和多模态模型方面仍存在一定局限。为此,树莓派正式发布了全新产品 —— Raspberry Pi AI HAT+ 2,这是其首款面向生成式 AI 场景设计的 AI 加速扩展板。

为 Raspberry Pi 5 解锁生成式 AI 能力

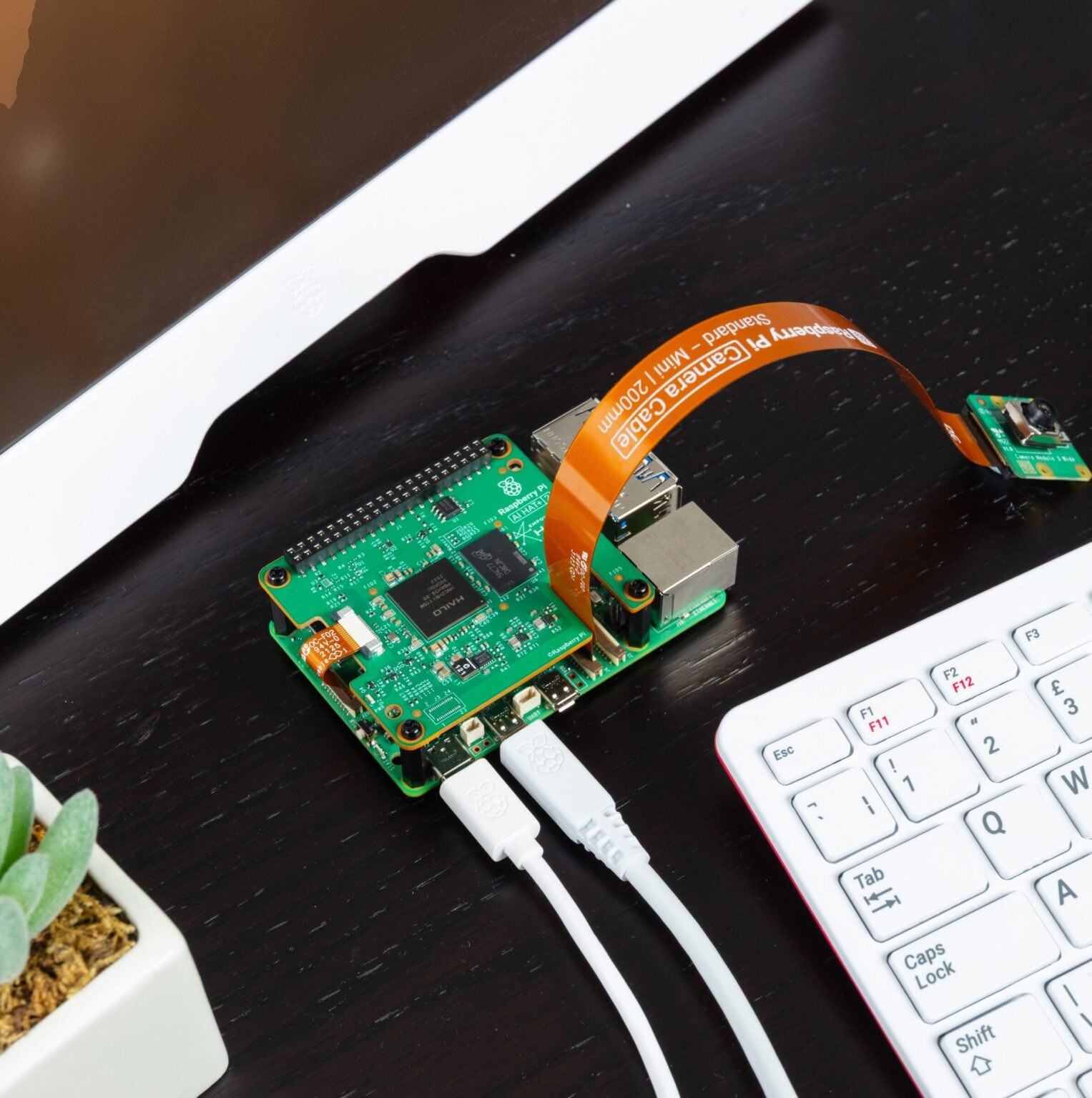

Raspberry Pi AI HAT+ 2 采用了全新的 Hailo-10H 神经网络加速芯片,提供高达 40 TOPS(INT4) 的推理性能,专为生成式 AI 工作负载优化。即使在完全离线的情况下,也能在 Raspberry Pi 5 上流畅运行多种生成式 AI 应用,具备 低延迟、高隐私、零云依赖 等显著优势。

与前代产品相比,AI HAT+ 2 最大的升级在于其 8GB 板载专用内存。这使得加速器能够高效处理更大规模的模型,为运行 大语言模型(LLM)、视觉-语言模型(VLM) 以及其他生成式 AI 应用提供了硬件基础。

视觉 AI 性能同样强大,迁移成本低

在传统视觉 AI 场景中(如基于 YOLO 的目标检测、姿态识别和场景分割),AI HAT+ 2 的整体表现与此前 26 TOPS 的 AI HAT+ 基本相当,并且得益于板载内存,在复杂模型处理上更加稳定。

同时,AI HAT+ 2 依然保持了与树莓派相机生态的深度整合,全面兼容 libcamera、rpicam-apps 和 Picamera2。对于已经在使用 AI HAT+ 的开发者来说,升级到 AI HAT+ 2 的过程几乎是无缝的,软件层面改动极少。

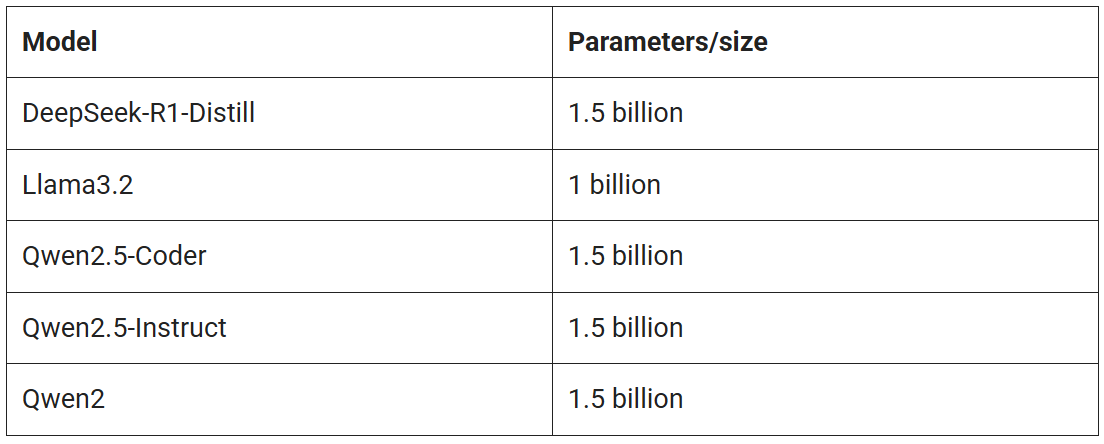

首批支持的大语言模型一览

在产品发布初期,以下 本地大语言模型 将率先提供安装支持:

树莓派官方表示,更多模型以及更大规模的模型正在适配中,预计将在后续更新中陆续上线。

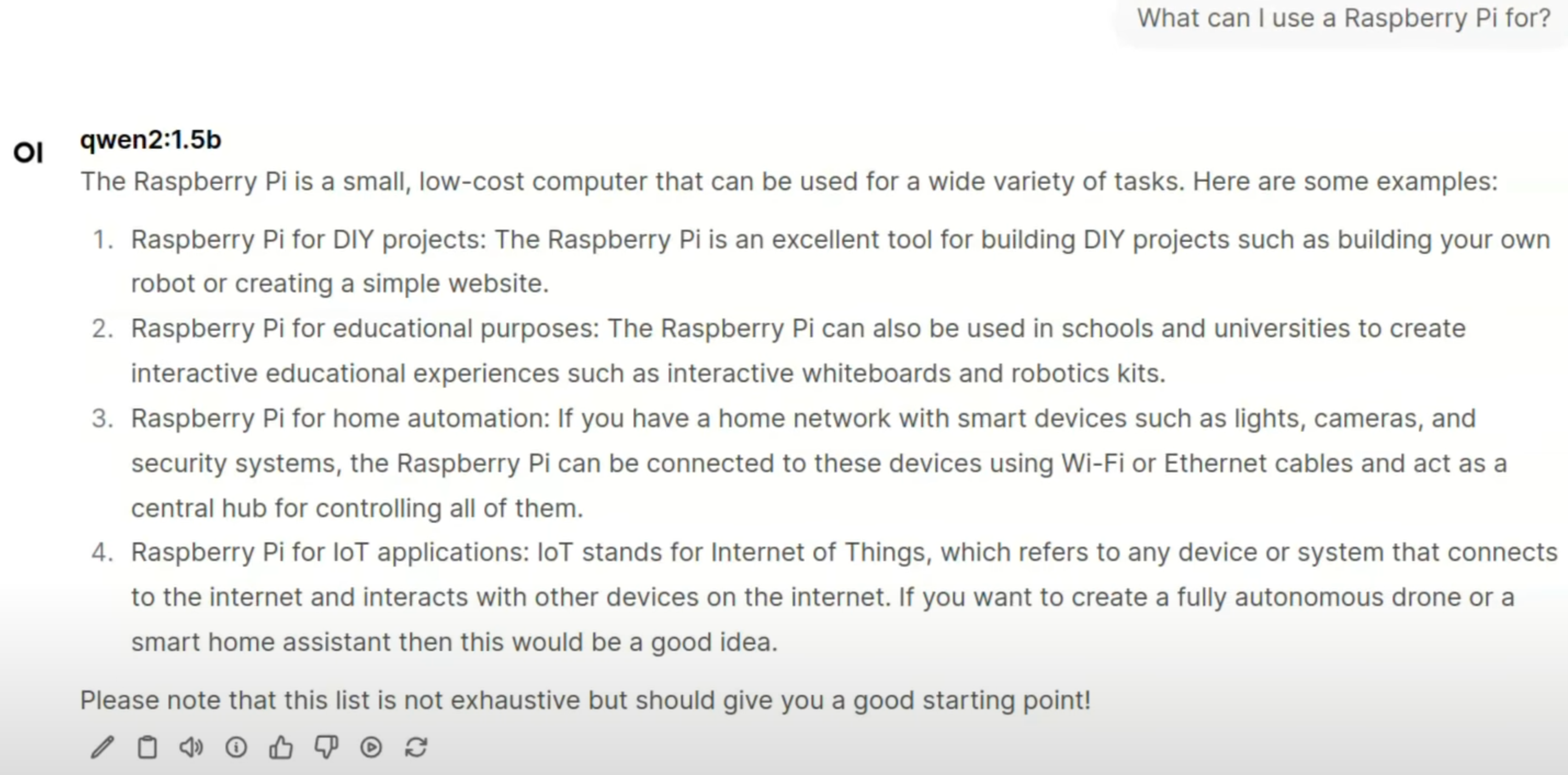

本地运行的大模型示例

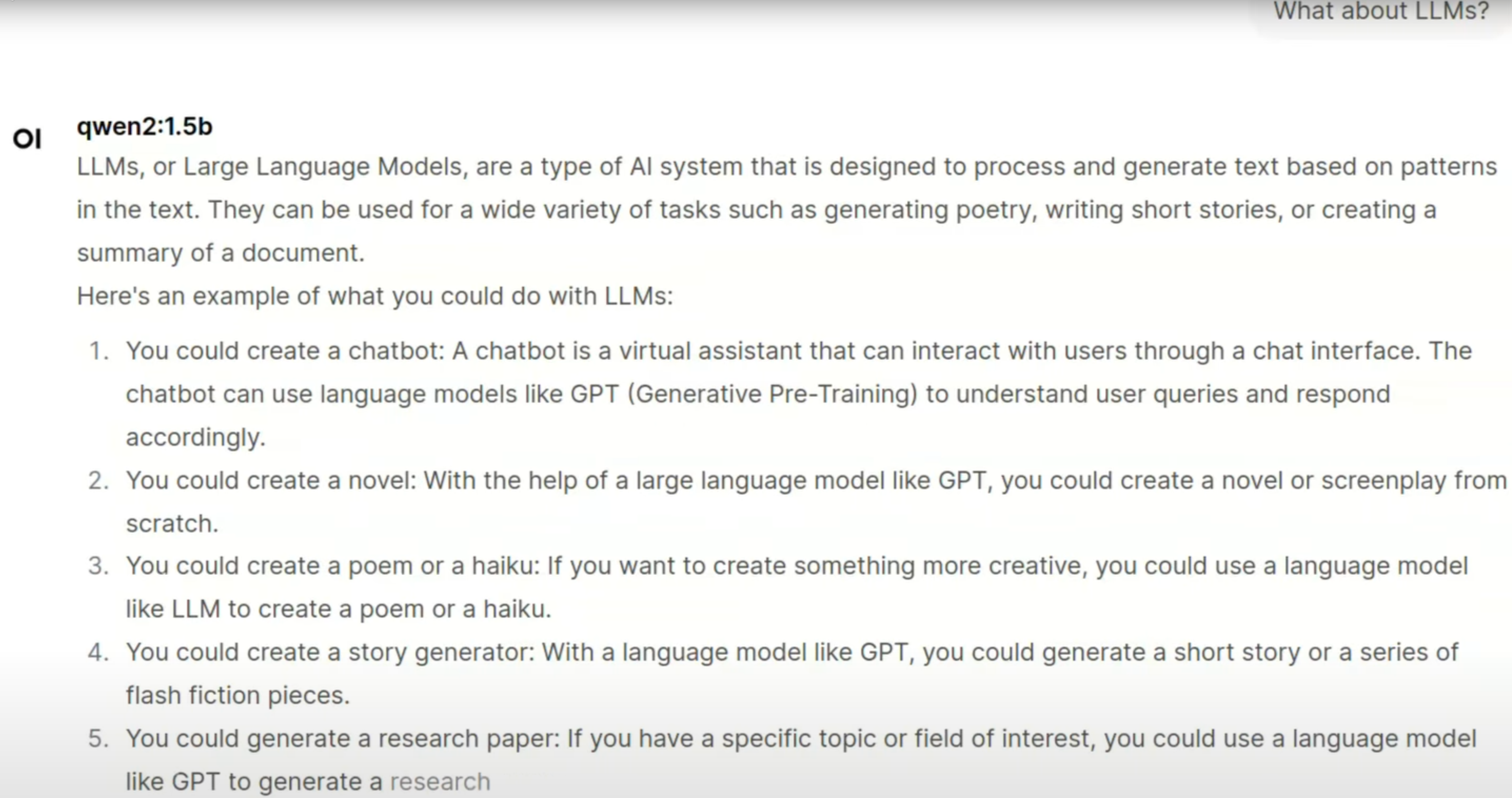

在官方演示中,树莓派 AI HAT+ 2 搭配 hailo-ollama 作为 LLM 推理后端,并使用 Open WebUI 提供类 ChatGPT 的网页交互界面。所有示例均运行在 Raspberry Pi 5 + AI HAT+ 2 设备上,完全本地执行,无需联网。

例如,使用 Qwen2 模型,设备即可完成日常问答、代码辅助等基础生成式 AI 任务,展示了树莓派在边缘 GenAI 领域的全新可能。

创客与开发者的新利器

随着 AI HAT+ 2 的发布,Raspberry Pi 正式迈入 生成式 AI 边缘计算 时代。这款产品不仅为创客、教育用户和嵌入式开发者提供了低门槛的本地大模型运行方案,也为隐私敏感、离线可用的 AI 应用场景打开了新的想象空间。

针对应用场景微调你的 AI 模型

目前最受关注的生成式 AI 模型,主要包括以 ChatGPT、Claude 为代表的 大语言模型(LLM),以 Stable Diffusion、DALL·E 为代表的 文生图 / 文生视频模型,以及近年来兴起的、融合视觉与语言能力的 视觉-语言模型(VLM)。

需要注意的是,这类模型在不同运行环境下存在明显差异。云端大模型(如 OpenAI、Meta、Anthropic 提供的模型)参数规模通常在 5000 亿到 2 万亿之间;而运行在 Raspberry Pi AI HAT+ 2 上的边缘端模型,则需要适配板载内存条件,参数规模通常为 10 亿到 70 亿。

这类小型 LLM 并不是为了在“通用知识量”上与云端模型竞争,而是更适合在 特定数据集和明确任务场景 下高效运行。

通过模型微调弥补模型规模差异

针对模型规模受限的问题,树莓派官方给出的解决方案是 —— 模型微调(Fine-tuning)。

在初代 Raspberry Pi AI HAT+ 上,开发者已经可以根据实际应用需求,对视觉模型(如 YOLO)使用特定图像数据集进行重新训练。AI HAT+ 2 延续了这一能力,并同样支持通过 Hailo Dataflow Compiler 完成模型训练和编译。

在语言模型方面,AI HAT+ 2 支持基于 LoRA(Low-Rank Adaptation,低秩适配) 的微调方式。该技术允许在保持大部分基础模型参数不变的前提下,仅针对特定任务训练少量适配参数,从而以更低的成本实现高效、定制化的模型能力。

开发者可以使用 Hailo Dataflow Compiler 为自己的应用场景编译 LoRA 适配器,并将微调后的模型直接部署运行在 Raspberry Pi AI HAT+ 2 上。

现已开售,生态资源完善

Raspberry Pi AI HAT+ 2 目前已正式开售,售价为 130 美元。官方同时提供了详细的 AI HAT 使用指南,帮助用户快速完成硬件安装与软件配置。

此外,Hailo 官方 GitHub 仓库中已经提供了大量示例项目、演示代码和应用框架,覆盖视觉 AI 与生成式 AI 场景,包括 VLM、多模态应用、语音助手以及语音识别等方向。

开发者还可以在 Hailo Developer Zone 中获取 Dataflow Compiler 和 hailo-ollama 服务的完整文档、教程及相关下载资源,进一步加速 AI 应用的开发与落地。

AI HAT+ 2 意味着什么?

在我们看来,Raspberry Pi AI HAT+ 2 是一次非常关键、也非常“务实”的升级。

过去,生成式 AI 往往意味着云端算力、高额费用和复杂部署,这对个人创客、小团队以及教学场景来说并不友好。而 AI HAT+ 2 将 大语言模型和多模态 AI 真正带到了树莓派这一熟悉的平台上,让“本地运行生成式 AI”不再只是概念,而是可以动手实践的现实。

8GB 板载内存与 Hailo-10H 的组合,使得运行 10~15 亿参数级别的大模型成为可能,这对于 本地助手、智能终端、私有化 AI 设备、教学实验 等场景具有非常高的价值。更重要的是,这一切都可以在 离线、低功耗、注重隐私 的前提下完成,这正是边缘计算和创客项目最看重的能力。

从创客工坊的角度来看,AI HAT+ 2 并不是要取代云端大模型,而是为开发者提供了一个可控、可实验、可落地的生成式 AI 平台。它非常适合作为学习 LLM 推理、构建本地 AI 应用、以及探索 AI + 硬件结合的起点。

我们也期待看到,未来会有更多围绕 AI HAT+ 2 的 开源项目、教学案例和创意应用 出现,让生成式 AI 不再只是“用 API 调用”,而是真正融入每一个动手实践的创客项目中。